Uma nova interface cérebro-computador ainda em fase experimental pode ajudar a restaurar a voz de pessoas que perderam a capacidade de falar devido a condições neurológicas. A tecnologia foi desenvolvida por pesquisadores da Universidade da Califórnia, em Davis, nos EUA.

O teste foi realizado com um portador de esclerose lateral amiotrófica (ELA), que teve a atividade cerebral traduzida pelo sistema de forma instantânea enquanto conversava com sua família. Os resultados foram publicados na revista científica Nature.

“Traduzir a atividade neural em texto, que é como nossa interface cérebro-computador anterior funciona, é semelhante a enviar mensagens de texto. É uma grande melhoria em comparação com as tecnologias assistivas padrão, mas ainda leva a conversas atrasadas. Em comparação, esta nova síntese de voz em tempo real é mais como uma chamada de voz”, disse Sergey Stavisky, autor sênior do artigo.

O grande diferencial

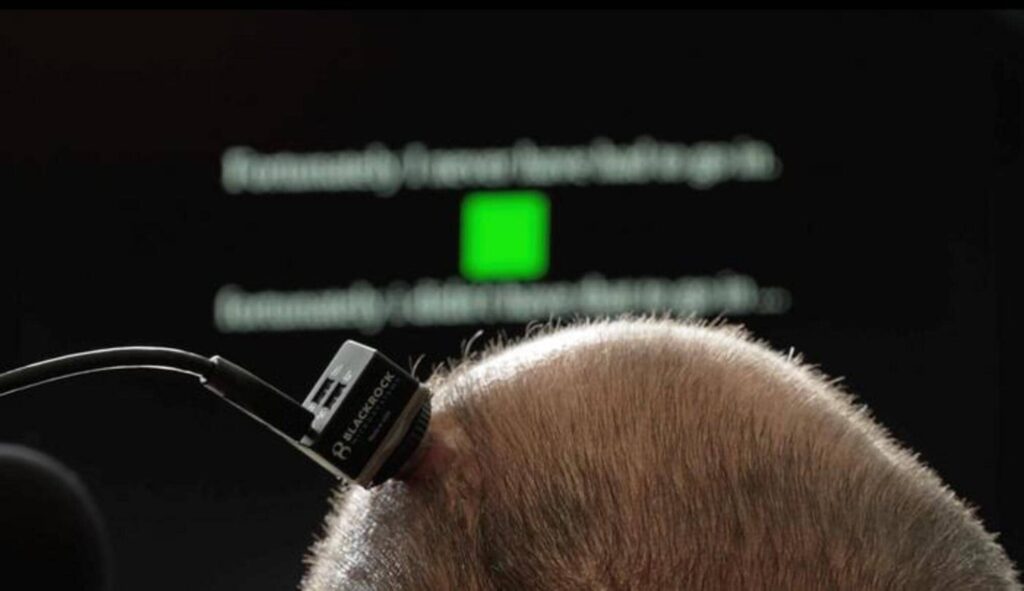

A interface é composta por quatro conjuntos de microeletrodos implantados cirurgicamente na região do cérebro responsável pela fala. Esses dispositivos registram a atividade dos neurônios e a enviam para computadores que interpretam os sinais para reconstruir a voz.

“A principal barreira para sintetizar a voz em tempo real era não saber exatamente quando e como a pessoa com perda de fala estava tentando falar”, disse Maitreyee Wairagkar, primeira autora do estudo. “Nossos algoritmos mapeiam a atividade neural para os sons pretendidos a cada momento. Isso possibilita sintetizar nuances na fala e dá ao participante controle sobre a cadência de sua voz BCI.”

O processo é auxiliado por algoritmos avançados de inteligência artificial treinados previamente. Os dados usados foram coletados enquanto o participante tentava pronunciar palavras ao ser instigado com frases mostradas a ele na tela do computador.

Leia Mais:

Resultados promissores

O sistema conseguiu traduzir os sinais neurais do participante do estudo em fala audível reproduzida por um alto-falante em um quadragésimo de segundo — atraso semelhante ao que uma pessoa sente quando fala e ouve o som da própria voz, segundo o estudo.

Além disso, o participante conseguiu cantar melodias simples e curtas, pronunciar palavras novas (desconhecidas pelo sistema) e modular a entonação para fazer uma pergunta ou enfatizar determinadas palavras. Os ouvintes conseguiam entender quase 60% das palavras sintetizadas corretamente; anteriormente, sem o uso da interface, esse número era de 4%.

Os resultados trazem esperança para pessoas que convivem com sequelas de condições neurológicas, mas ainda são limitados. Os pesquisadores ponderam que o estudo foi realizado apenas com um paciente, e que serão necessários testes mais amplos. O estudo BrainGate2 está recrutando participantes.

Em abril, um paciente com esclerose lateral amiotrófica (ELA) se tornou o primeiro paciente não verbal a utilizar um implante cerebral da Neuralink para se comunicar apenas com o pensamento, como relatou o Olhar Digital.